Diferenciabilidade

Teorema da função inversa

Dada uma aplicação linear \(A:\mathbb{R}^n\to \mathbb{R}^n\) a condição do determinante da matriz que a representa ser não nulo é equivalente a \(A\) ser uma bijecção. Em que medida é que uma condição similar relativa ao determinante da matriz jacobiana tem reflexos no facto de podermos definir uma inversa de uma função de classe \(C^1\) de \(\mathbb{R}^n\) em \(\mathbb{R}^n\)? Vamos ver que a resposta é em geral negativa mas, se nos contentarmos com uma invertibilidade local de \(F\) a resposta é afirmativa. Tal é o conteúdo do teorema da função da inversa.

Se \(g:\mathbb{R}\to \mathbb{R}\) é uma função de classe \(C^1\) para a qual \(g'(t)\neq 0\) para todo o \(t\in\mathbb{R}\) então podemos concluir que \(g\) é uma função estritamente monótona em \(\mathbb{R}\). Este facto poderia levantar expectativas que se revelam infundadas para funções \(F:\mathbb{R}^n\to\mathbb{R}^n\) verificando \(F\in C^1(\mathbb{R}^n)\) e \(\det J_F(\boldsymbol{x})\neq 0\) para todo o \(\boldsymbol{x}\in \mathbb{R}^n\).

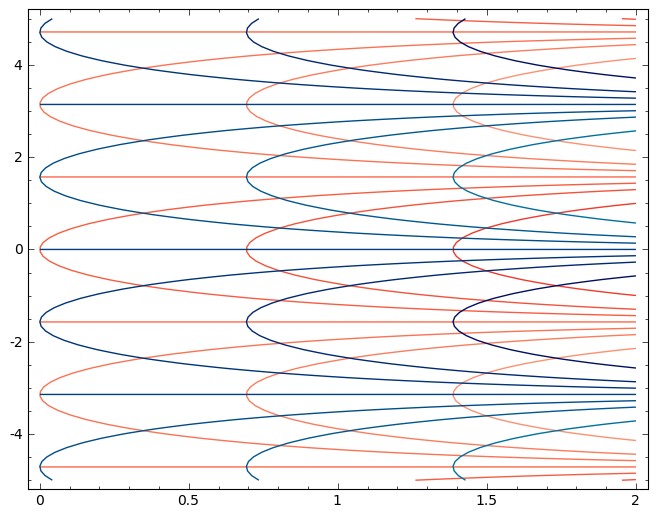

Exemplo. Seja \(F:\mathbb{R}^2\to \mathbb{R}^2\) definida por \(F(x,y)=(e^x\cos y, e^x\operatorname{sen} y)\)

Temos \(F(x,y+2\pi) =F(x,y)\) para todos os \((x,y)\in\mathbb{R}^2\) pelo que a função não é injectiva. No entanto \[J_F(x,y)=\begin{bmatrix}e^x\cos y & -e^x\operatorname{sen} y \\ e^x\operatorname{sen} y & e^x\cos y\end{bmatrix}\]e \(\det J_F(x,y)=e^{2x}\gt 0\). Note-se no entanto que a restrição de \(F\) a uma "faixa horizontal" \(\{(x,y)\in\mathbb{R}^2: \alpha \lt y\lt \alpha + 2\pi\}\) é uma função injectiva. Fim de exemplo.

O teorema da função inversa vai simplesmente garantir que se o determinante da matriz jacobiana de uma aplicação \(C^1\) definida numa aberto de \(\mathbb{R}^n\) com valores em \(\mathbb{R}^n\) é não nulo num dado ponto, então existe uma vizinhança do ponto onde a aplicação é injectiva e a inversa dessa função é também de classe \(C^1\).

Uma possível estratégia de demonstração do teorema baseia-se em considerar uma linearização da equação \(F(\boldsymbol{x})=\boldsymbol{y}\) perto do ponto onde a matriz jacobiana é não nula e mostrar sucessivamente que essa linearização permite construir, desde que comecemos suficientemente perto do ponto, uma sucessão que converge para uma solução da equação e que essa solução é uma função de classe \(C^1\) de \(\boldsymbol{y}\).

Detalhemos então pelo menos parte deste programa de demonstração do teorema.

Supomos então que \(A\subset\mathbb{R}^n\) é um aberto, \(F:A\to \mathbb{R}^n\) é uma função de classe \(C^1(A)\), \(\boldsymbol{x}_0\in A\) e \(\det J_F(\boldsymbol{x}_0)\neq 0\). Designamos \(\boldsymbol{y}_0=F(\boldsymbol{x}_0)\).

O nosso objectivo é mostrar que existem abertos $V\ni \boldsymbol{y}_0$ e $U\ni \boldsymbol{x}_0$ tais que $F$ é uma bijecção de $U$ sobre $V$ e que $G=(F|_U)^{-1}$ é uma função diferenciável. Note-se que, se esse objectivo for atingido, o teorema de derivação da função composta garante imediatamente que $DG(F(\boldsymbol{x}))DF(\boldsymbol{x})=D(G\circ F)(\boldsymbol{x})=I$, com $I$ a aplicação linear identidade, para todo o $\boldsymbol{x}\in U$, o que nos permite relacionar as derivadas de $F$ e $G$ e, atendendo ao que sabemos do processo de cálculo da matriz inversa, justifica que $G\in C^1(V)$.

Substituímos temporariamente a consideração da equação \(F(\boldsymbol{x})=\boldsymbol{y}\) para \(\boldsymbol{x}\) “perto” de \(\boldsymbol{x}_0\) e \(\boldsymbol{y}\) “perto” de \(\boldsymbol{y}_0\) pela consideração da equação linearizada \[F(\boldsymbol{x}_0)+DF(\boldsymbol{x}_0)(\boldsymbol{x}-\boldsymbol{x}_0)=\boldsymbol{y}\] cuja solução é \[\boldsymbol{x}= \boldsymbol{x}_0 + DF(\boldsymbol{x}_0)^{-1}(\boldsymbol{y}-F(\boldsymbol{x}_0)).\]

A igualdade anterior pode ser interpretada como calculando, a partir de uma primeira aproximação à solução de \(F(\boldsymbol{x})=\boldsymbol{y}\), uma nova aproximação através de um operador \(T_{\boldsymbol{y}}\) definido por \[T_{\boldsymbol{y}}(\boldsymbol{x})=\boldsymbol{x} + DF(\boldsymbol{x}_0)^{-1}(\boldsymbol{y}-F(\boldsymbol{x})).\]

Toda a ideia da demonstração consiste em provar que, se recursivamente voltarmos a repetir este processo, construímos uma sucessão convergente para uma solução da equação original, desde que tenhamos considerado \(\boldsymbol{y}\) suficientemente perto de \( \boldsymbol{y}_0=F(\boldsymbol{x}_0)\). Esta ideia para solução de equações não lineares é conhecida por método de Newton, frequentemente utilizado para cálculo numérico.

Consideramos então \(\boldsymbol{y}\in B_\epsilon(\boldsymbol{y}_0)\), com $\epsilon\gt 0$ a ser restringido posteriormente, e definimos uma sucessão recursivamente via \[\boldsymbol{x}_{k+1}=T_{\boldsymbol{y}}(\boldsymbol{x}_k), \text{ para } k\in\mathbb{N}.\]

Como \[\boldsymbol{x}_{k+1}=\boldsymbol{x}_{k+1} - \boldsymbol{x}_k + \boldsymbol{x}_k = \boldsymbol{x}_{k+1} - \boldsymbol{x}_k + \boldsymbol{x}_k - \boldsymbol{x}_{k-1} + \boldsymbol{x}_{k-1}=\dots =\sum_{j=1}^k ( \boldsymbol{x}_{j+1} - \boldsymbol{x}_j) + \boldsymbol{x}_0, \] provar a convergência da sucessão é equivalente a provar a convergência da série telescópica \[\sum_{j=0}^{+\infty}(\boldsymbol{x}_{j+1}-\boldsymbol{x}_{j}),\] sendo o limite da sucessão igual a \(\boldsymbol{x}_0\) mais a soma da série.

Por sua vez, para provar a convergência da série $\sum (\boldsymbol{x}_{j+1}-\boldsymbol{x}_{j})$, mostramos que a série das normas dos seus termos pode ter o seu termo geral majorado por o de uma série geométrica de razão menor que $1$, desde que que tenhamos a garantia de que todos os $\boldsymbol{x}_{j}$ estão numa bola $B_r(\boldsymbol{x}_0)$ com raio \(r\gt 0\) suficientemente pequeno.

Que a convergência da série das normas implica a convergência de uma série de termos em \(\mathbb{R}^n\), tem uma demonstração análoga à demonstração do teorema sobre convergência absoluta de séries numéricas.

Os detalhes deste programa vão ser dependentes do teorema de Lagrange para funções vectoriais.

Sejam \(\boldsymbol{x},\boldsymbol{z}\in B_r(\boldsymbol{x}_0)\subset A\). Então \[T_{\boldsymbol{y}}(\boldsymbol{x})-T_{\boldsymbol{y}}(\boldsymbol{z})=\boldsymbol{x}-\boldsymbol{z}-DF(\boldsymbol{x}_0)^{-1}(F(\boldsymbol{x})-F(\boldsymbol{z}))\] o que sugere considerar a função \(\boldsymbol{x}\mapsto \boldsymbol{x}-DF(\boldsymbol{x}_0)^{-1}F(\boldsymbol{x})\equiv H(\boldsymbol{x})\) para aplicação do teorema de Lagrange para funções vectoriais. A derivada desta função é \(DH(\boldsymbol{x})=I-DF(\boldsymbol{x}_0)^{-1}DF(\boldsymbol{x})\) em que \(I\) designa a aplicação linear identidade. Note-se que todas as derivadas parciais na matriz jacobiana de \(H\), tendem para \(0\) quando \(\boldsymbol{x}\to\boldsymbol{x}_0\). Assim, dado um qualquer \(\alpha\) com \(1\gt \alpha\gt 0\), é possível escolher \(\delta\), com $0\lt \delta\lt r$, tal que para \(\boldsymbol{x}, \boldsymbol{z}\in B_\delta(\boldsymbol{x}_0)\) temos \[\begin{equation}\|T_{\boldsymbol{y}}(\boldsymbol{x})-T_{\boldsymbol{y}}(\boldsymbol{z})\|\leq \alpha\|\boldsymbol{x}-\boldsymbol{z}\|\label{eq:contracao}\end{equation}\] donde \[\|\boldsymbol{x}_{k+1}-\boldsymbol{x}_k\|\leq \alpha \|\boldsymbol{x}_{k}-\boldsymbol{x}_{k-1}\| \leq\dots\leq \alpha^k\|\boldsymbol{x}_{1}-\boldsymbol{x}_0\|\] desde que tenhamos a garantia de que cada \(\boldsymbol{x}_k\) está na bola \(B_\delta(\boldsymbol{x}_0)\).

Para justificarmos que os termos da sucessão $(\boldsymbol{x}_k)$ não se afastam de mais de $\boldsymbol{x}_0$ estimamos, para $\boldsymbol{x}\in B_\delta(\boldsymbol{x}_0)$ e $\boldsymbol{y}\in B_\epsilon(\boldsymbol{y}_0)$, \begin{align*}\|T_{\boldsymbol{y}}(\boldsymbol{x})-\boldsymbol{x}_0\| & =\|T_{\boldsymbol{y}}(\boldsymbol{x})-T_{\boldsymbol{y}}(\boldsymbol{x}_0)+T_{\boldsymbol{y}}(\boldsymbol{x}_0)-\boldsymbol{x}_0\|\\ & \leq \alpha \|\boldsymbol{x}-\boldsymbol{x}_0\| + \| DF(\boldsymbol{x}_0)^{-1}(\boldsymbol{y}-\boldsymbol{y}_0)\| \\ & \leq \alpha \delta + M \epsilon\end{align*} para alguma constante $M\gt 0$ tal que $\|DF(\boldsymbol{x}_0)^{-1}\boldsymbol{u}\|\leq M\|\boldsymbol{u}\|$ para qualquer $\boldsymbol{u}\in\mathbb{R}^n$ (relembre a discussão da continuidade das aplicações lineares).

Portanto, se $\epsilon\lt (1-\alpha)/M$, temos $\|T_{\boldsymbol{y}}(\boldsymbol{x})-\boldsymbol{x}_0\|\lt \delta$, ou seja $T_{\boldsymbol{y}}(\boldsymbol{x})\in B_\delta(\boldsymbol{x}_0)$, o que nos garante que a convergência da sucessão de aproximações está garantida se $\delta$ e $\epsilon$ forem escolhidos suficientemente pequenos.

Seja \(\boldsymbol{x}^\ast\in B_{\delta}(\boldsymbol{x}_0)\) o limite da sucessão $(\boldsymbol{x}_k)$. Note-se que, como depende de $\boldsymbol{y}\in B_\epsilon(\boldsymbol{y}_0)$, será conveniente designarmo-lo por \(G(\boldsymbol{y})\) sempre que necessário.

Passando ao limite na igualdade \(T_y(\boldsymbol{x}_k)=\boldsymbol{x}_{k+1}\), usando a continuidade de $T_{\boldsymbol{y}}$ como função de $\boldsymbol{x}$, obtemos que \(\boldsymbol{x}^\ast\) é uma solução de \(T_y(\boldsymbol{x})=\boldsymbol{x}\) e portanto de \(F(\boldsymbol{x})=\boldsymbol{y}\). Estabeleceu-se portanto a existência de solução local da equação \(F(\boldsymbol{x})=\boldsymbol{y}\) na forma $\boldsymbol{x}=G(\boldsymbol{y})$.

Teorema (da Função Inversa). Seja \(F:A\subset\mathbb{R}^n\to \mathbb{R}^n\), com \(A\) um aberto, \(F\in C^1(A)\), \(\boldsymbol{x}_0\in A\) e \(\det J_F(\boldsymbol{x}_0)\neq 0\). Então existem abertos \(U\ni \boldsymbol{x}_0\) e \(V\ni F(\boldsymbol{x}_0)\) tais que a restrição de \(F\) a \(U\) é uma bijecção sobre \(V\) e a inversa dessa restrição é uma função de classe \(C^1\).

Conclusão da demonstração

Prosseguimos mostrando que a restrição de $F$ a $B_\delta(\boldsymbol{x}_0)$ é injectiva. Para tal, começamos por tornar $\delta$ mais pequeno se necessário, de maneira a que adicionalmente $\boldsymbol{x}\in B_\delta(\boldsymbol{x}_0)$ garanta que $F(\boldsymbol{x})\in B_\epsilon(\boldsymbol{y}_0)$, graças à continuidade de $F$. Então, se a restrição de $F$ a $B_\delta(\boldsymbol{x}_0)$ não fosse injectiva, existiriam $\boldsymbol{x}, \boldsymbol{z}\in B_\delta(\boldsymbol{x}_0)$ com $\boldsymbol{x}\neq \boldsymbol{z}$ tais que \[F(\boldsymbol{x})=F(\boldsymbol{z})=\boldsymbol{y}\in B_\epsilon(\boldsymbol{y}_0).\] Mas, nestas condições, também $T_\boldsymbol{y}(\boldsymbol{x})=\boldsymbol{x}$ e $ T_\boldsymbol{y}(\boldsymbol{z})=\boldsymbol{z}$, algo que não é possível pois, por ($\ref{eq:contracao}$), temos \[\| \boldsymbol{x} - \boldsymbol{z}\| = \|T_\boldsymbol{y}(\boldsymbol{x})-T_\boldsymbol{y}(\boldsymbol{z})\|\leq \alpha \| \boldsymbol{x} - \boldsymbol{z}\|,\] algo só possível se $\boldsymbol{x}=\boldsymbol{z}$.

Escolhemos $U$ e $V$ via \[\begin{align*} U & =F^{-1}(B_\epsilon(F(\boldsymbol{x}_0)))\cap B_\delta(\boldsymbol{x}_0) \\ V & =F(U).\end{align*}\] Que $U$ é aberto é uma consequência da continuidade de $F$. Que $V$ é aberto irá ser uma consequência da injectividade de $F$ (ou da continuidade de $G$ que estabelecemos a seguir).

Para estabelecer a continuidade de $G$ sejam $\gamma\gt 0$ dado e $\boldsymbol{y}_1, \boldsymbol{y}_2 \in B_\epsilon(F(\boldsymbol{x}_0))$. Começamos por estimar \[\begin{equation}\|G(\boldsymbol{y}_1)-G(\boldsymbol{y}_2)\|\leq \|G(\boldsymbol{y}_1)-T^k_{\boldsymbol{y}_1}(\boldsymbol{x}_0)\| + \| T^k_{\boldsymbol{y}_1}(\boldsymbol{x}_0) - T^k_{\boldsymbol{y}_2}(\boldsymbol{x}_0)\| + \| T^k_{\boldsymbol{y}_2}(\boldsymbol{x}_0)-G(\boldsymbol{y}_2)\| \label{eq:sample} \end{equation}\] em que $T^k_{\boldsymbol{y}}$ é a composição da função $T_{\boldsymbol{y}}$ consigo própria $k$ vezes, isto é $T^k_{\boldsymbol{y}}=T_{\boldsymbol{y}} \circ T^{k-1}_{\boldsymbol{y}}$ para $k\gt 1$ e $T^1_{\boldsymbol{y}}=T_{\boldsymbol{y}}$. Para prosseguir vamos começar por estimar o termo do meio do lado direito da desigualdade. Seja $M\gt 0$ tal que $\|DF(\boldsymbol{x}_0)^{-1}(\boldsymbol{z})\|\leq M \| \boldsymbol{z}\|$ para todo o $\boldsymbol{z}\in\mathbb{R}^n$. Então \[\begin{align*}\| T^k_{\boldsymbol{y}_1}(\boldsymbol{x}_0) - T^k_{\boldsymbol{y}_2}(\boldsymbol{x}_0)\| & \leq M \|\boldsymbol{y}_1 - \boldsymbol{y}_2\| + \alpha \| T^{k-1}_{\boldsymbol{y}_1}(\boldsymbol{x}_0) - T^{k-1}_{\boldsymbol{y}_2}(\boldsymbol{x}_0)\| \leq \dots \\ & \leq M(\alpha^{k-1}+\dots +\alpha + 1)\|\boldsymbol{y}_1 - \boldsymbol{y}_2\| \leq \frac{M}{1-\alpha} \|\boldsymbol{y}_1 - \boldsymbol{y}_2\|. \end{align*}\]

Podemos assim escolher $r\gt 0$ tal que $\|\boldsymbol{y}_1 - \boldsymbol{y}_2\|\lt r$ garante $\| T^k_{\boldsymbol{y}_1}(\boldsymbol{x}_0) - T^k_{\boldsymbol{y}_2}(\boldsymbol{x}_0)\|\lt \gamma/3$ independentemente de $k$. Em particular podemos assumir que $k$ é suficientemente grande de maneira a garantir que os dois outros termos que precisamos de estimar em $(\ref{eq:sample})$ também são menores que $\gamma/3$. Isto estabelece a continuidade de $G$.

Falta-nos mostrar que a função que designámos por \(G\) é uma função de classe \(C^1\). Comecemos por notar que bastará mostrar que $G$ é diferenciável. Com efeito, como já observámos ao discutir o teorema de derivação da função composta, \(G(F(\boldsymbol{x}))=\boldsymbol{x}\) em \(U\) e derivando a igualdade obtemos a derivada da inversa local em função da derivada de \(F\), isto é, \[DG(F(\boldsymbol{x}))=DF(\boldsymbol{x})^{-1}\] em \(U\). A fórmula de cálculo de uma matriz inversa e a continuidade das operações algébricas permitem garantir a continuidade das derivadas parciais de $G$.

Além disso basta-nos estabelecer a diferenciabilidade de $G$ em $\boldsymbol{y}_0$ pois, graças a $F\in C^1$ e à unicidade da inversa local que já estabelecemos, o mesmo argumento será aplicável noutros pontos de $B_\delta (\boldsymbol{x}_0)$ com $\delta \gt 0$ suficientemente pequeno para garantir que em todos os pontos $\boldsymbol{x}$ dessa bola temos $\operatorname{det}DF(\boldsymbol{x})\neq 0$.

Vamos então estabelecer que $G$ é diferenciável em $\boldsymbol{y}_0$ com a sua derivada igual a $DF(\boldsymbol{x}_0)^{-1}$. Isto corresponde a mostrar que \[\lim_{\boldsymbol{y}\to\boldsymbol{y}_0} \frac{G(\boldsymbol{y})-G(\boldsymbol{y}_0)-DF(\boldsymbol{x}_0)^{-1}(\boldsymbol{y}-\boldsymbol{y}_0)}{\|\boldsymbol{y}-\boldsymbol{y}_0\|}=\boldsymbol{0}.\] Para justificar este limite iremos mostrar que \begin{equation}\lim_{\boldsymbol{y}\to\boldsymbol{y}_0} \frac{G(\boldsymbol{y})-G(\boldsymbol{y}_0)-DF(\boldsymbol{x}_0)^{-1}(\boldsymbol{y}-\boldsymbol{y}_0)}{\|G(\boldsymbol{y})-G(\boldsymbol{y}_0)\|}=\boldsymbol{0}, \label{eq:lim_dif_inv}\end{equation} e que existe uma vizinhança de $ \boldsymbol{y}_0 $ onde \begin{equation} \frac{\|G(\boldsymbol{y})-G(\boldsymbol{y}_0)\|}{\|\boldsymbol{y}-\boldsymbol{y}_0\|} \label{eq:lip_G}\end{equation} é limitado.

A continuidade de $G$ permite estabelecer ($\ref{eq:lim_dif_inv}$) à custa de provar que \[\lim_{\boldsymbol{x}\to \boldsymbol{x}_0}\frac{\boldsymbol{x}- \boldsymbol{x}_0 - DF(\boldsymbol{x}_0)^{-1}(F(\boldsymbol{x})-F(\boldsymbol{x}_0))}{\|\boldsymbol{x}- \boldsymbol{x}_0\|}=\boldsymbol{0}.\] Tal decorre da diferenciabilidade de $F$ em $\boldsymbol{x}_0$.

Quanto a ($\ref{eq:lip_G}$) ser limitado, escreva-se, usando a diferenciabilidade de $F$ em $\boldsymbol{x}_0$, \[\begin{equation}\begin{aligned}\frac{\|G(\boldsymbol{y})-G(\boldsymbol{y}_0)\|}{\|\boldsymbol{y}-\boldsymbol{y}_0\|} & = \frac{\|\boldsymbol{x}-\boldsymbol{x}_0\|}{\|F(\boldsymbol{x})-F(\boldsymbol{x}_0)\|}= \frac{\|\boldsymbol{x}-\boldsymbol{x}_0\|}{\|DF(\boldsymbol{x}_0)(\boldsymbol{x}-\boldsymbol{x}_0)+ o(\|\boldsymbol{x}-\boldsymbol{x}_0\|)\|} \\ & \leq \frac{1}{\left| \left\|DF(\boldsymbol{x}_0)\left(\frac{\boldsymbol{x}-\boldsymbol{x}_0}{\|\boldsymbol{x}-\boldsymbol{x}_0\|}\right)\right\| - \frac{\|o(\|\boldsymbol{x}-\boldsymbol{x}_0\|)\|}{\|\boldsymbol{x}-\boldsymbol{x}_0\|}\right|}\end{aligned}\label{ineq}\end{equation}\] em que $o(\|\boldsymbol{x}-\boldsymbol{x}_0\|)$ é tal que $\lim_{\boldsymbol{x}\to\boldsymbol{x}_0}\frac{o(\|\boldsymbol{x}-\boldsymbol{x}_0\|)}{\|\boldsymbol{x}-\boldsymbol{x}_0\|}=\boldsymbol{0}$. Como o argumento de $DF(\boldsymbol{x}_0)\left(\frac{\boldsymbol{x}-\boldsymbol{x}_0}{\|\boldsymbol{x}-\boldsymbol{x}_0\|}\right)$ é um vector unitário e a fronteira da bola unitária é um limitado e fechado podemos usar o teorema de Weierstrass para garantir que $\left\|DF(\boldsymbol{x}_0)\left(\frac{\boldsymbol{x}-\boldsymbol{x}_0}{\|\boldsymbol{x}-\boldsymbol{x}_0\|}\right)\right\|$ tem um mínimo. Se esse mínimo fosse $0$ então $DF(\boldsymbol{x}_0)$ teria um valor próprio nulo e portanto não seria invertível. Logo conseguimos minorar o denominador da fracção do lado direito da desigualdade ($\ref{ineq}$) por um número positivo desde que $\boldsymbol{x}$ esteja suficientemente perto de $\boldsymbol{x}_0$.

Fim da conclusão da demonstração.

Note-se, como já observámos ao discutir o teorema de derivação da função composta, que se designarmos a inversa local por \(G\), então \(G(F(\boldsymbol{x}))=\boldsymbol{x}\) em \(U\) e derivando a igualdade obtemos a derivada da inversa local em função da derivada de \(F\), isto é, \[DG(F(\boldsymbol{x}))=DF(\boldsymbol{x})^{-1}\] em \(U\).

Exemplo. Considere-se \(F:\{(x,y)\in\mathbb{R}^2: x+y\gt 0\}\to \mathbb{R}^2\) definida por \[F(x,y)=(e^{x}+\log(x+y), x+y+y^2).\] Trata-se de uma função de classe \(C^1\) no seu domínio, sendo a respectiva matriz jacobiana \[J_F(x,y)=\begin{bmatrix}e^{x}+\frac{1}{x+y} & \frac{1}{x+y} \\ 1 & 1+2y \end{bmatrix}\] e, em particular, \[J_F(0,1)=\begin{bmatrix}2 & 1 \\ 1 & 3 \end{bmatrix}\] donde \(\det(J_F(0,1))=5\gt 0\). Daí que existam abertos \(U, V\) com \((0,1)\in U\) e \(F(0,1)=(0,2)\in V\) tais que \(F\) é uma bijecção de \(U\) sobre \(V\) com inversa \(G\in C^1(V)\) verificando \[J_G(0,2)= \begin{bmatrix}2 & 1 \\ 1 & 3 \end{bmatrix}^{-1}=\frac{1}{5}\begin{bmatrix}3 & -1 \\ -1 & 2 \end{bmatrix}.\]

Exercício. Justifique que se a função for de classe \(C^1\) e se se mostrar que a inversa local é diferenciável então a inversa local é de classe \(C^1\).

Exercício. Mostre que a inversa local no teorema da função inversa é de classe $C^k$ com $k\gt 1$, se supusermos adicionalmente que $F\in C^k(A)$,

Última edição desta versão: João Palhoto Matos, 23/04/2021 08:34:07.